AI yang baru dirancang untuk memprediksi kejahatan sebelum terjadi, kini telah diuji di beberapa kota AS. Secara akurat dapat memprediksi peristiwa sekitar 80-90 persen dari waktu. AI seharusnya dirancang untuk pengoptimalan kebijakan dan alokasi sumber daya bagi area kota yang paling membutuhkannya, tetapi banyak kekhawatiran tentang rekam jejak AI yang buruk dan bias yang melekat padanya.

Profesor Ishanu Chattopadhyay dan rekannya mendemonstrasikan model AI prediktif di delapan kota besar AS. Konsepnya sederhana: Kota Chicago merilis log peristiwa untuk setiap kejahatan, termasuk di mana dan kapan kejahatan itu terjadi, dan data ini dimasukkan ke dalam algoritme pembelajaran mesin.

Kemudian, kota ini dipisahkan menjadi potongan 90 meter persegi dan log peristiwa digabungkan dengan area untuk menciptakan apa yang disebut para peneliti sebagai “deret waktu”. AI kemudian menggunakan deret waktu ini untuk memprediksi kejahatan berdasarkan di mana dan kapan sering terjadi.

Pada dasarnya, model dapat mengatakan “kemungkinan akan ada perampokan bersenjata di area tertentu pada hari tertentu”, tetapi tidak mengatakan siapa yang akan melakukannya. Ini membedakannya dari teknologi lain yang digunakan untuk mendeteksi kejahatan, seperti AI yang sebelumnya dilaporkan dapat mengidentifikasi orang-orang yang kemungkinan besar adalah penjahat.

“Masyarakat khawatir ini akan digunakan sebagai alat untuk menjebloskan orang ke penjara sebelum mereka melakukan kejahatan. Itu tidak akan terjadi, karena tidak memiliki kemampuan untuk melakukan itu. Ia hanya memprediksi suatu peristiwa di lokasi tertentu,” kata Chattopadhyay kepada BBC Science Focus .

“Itu tidak memberi tahu Anda siapa yang akan melakukan acara atau dinamika atau mekanisme acara yang tepat.”

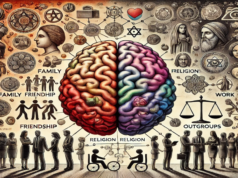

Hal ini menimbulkan salah satu pertanyaan paling penting tentang masalah ini – dalam tema banyak AI prediktif sosial lainnya, apakah model ini menjadi mangsa bias rasis dan sosio-ekonomi yang melumpuhkan yang telah dilakukan banyak orang sebelumnya?

Menurut Chattopadhyay, metode yang mereka gunakan untuk melatih model memungkinkannya menghindari bias ini, karena hanya log peristiwa yang dimasukkan ke dalamnya. Ada sangat sedikit input manual, dan ini seharusnya merupakan hal yang baik.

“Kami telah berusaha untuk mengurangi bias sebanyak mungkin. Begitulah model kami berbeda dari model lain yang telah datang sebelumnya,” tambahnya.

Sekarang masih harus dilihat apakah kota-kota akan mulai menggunakan model seperti itu untuk pembuatan kebijakan, atau apakah mereka akan menghindari berdasarkan rekam jejak gelapnya. Para peneliti tampaknya yakin AI mereka dapat mengatasi masalah ini, tetapi mengingat cakupan luas untuk penyalahgunaan yang dimiliki sistem semacam itu, banyak yang masih skeptis.

Penelitian ini diterbitkan di Nature Human Behavior.